Modelos de Probabilidad: Guía para Científicos de Datos

Introducción a los Modelos de Probabilidad

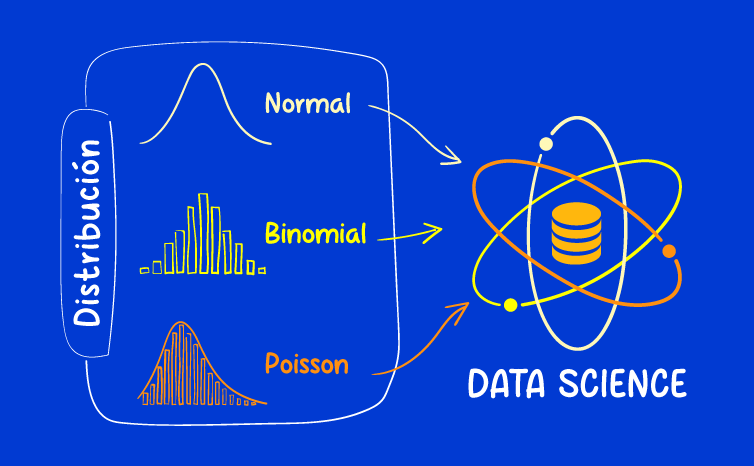

En el dinámico campo de la ciencia de datos, los modelos de probabilidad son herramientas esenciales para entender y predecir fenómenos inciertos en diversos contextos.

¿Qué es un Modelo de Probabilidad?

Los modelos de probabilidad permiten a los científicos de datos trabajar con incertidumbre y tomar decisiones informadas. Una distribución de probabilidad describe la probabilidad de ocurrencia de cada posible resultado en un experimento aleatorio. Las distribuciones más utilizadas incluyen la normal, binomial y de Poisson.

Distribución Normal

La distribución normal, también conocida como la campana de Gauss, es central en la teoría de probabilidades y estadísticas. Caracterizada por su forma simétrica en campana, está definida por dos parámetros: la media y la desviación estándar. Es aplicable en numerosos contextos, desde la física hasta las finanzas, donde se utiliza para modelar variables continuas como el rendimiento de acciones o la altura de individuos en una población.

Aplicaciones de la Distribución Normal

Finanzas: Modelar rendimientos de activos y evaluar riesgos.

Medicina: Analizar distribuciones de variables biomédicas.

Psicología: Evaluar pruebas estandarizadas y coeficientes intelectuales.

Distribución Binomial

La distribución binomial describe el número de éxitos en una secuencia de ensayos independientes, donde cada ensayo tiene dos resultados posibles: éxito o fracaso, con una probabilidad constante de éxito en cada ensayo

Aplicaciones de la Distribución Binomial

Ciencia: Análisis de resultados de experimentos.

Toma de decisiones: Evaluar encuestas de opinión pública.

Medicina: Determinar la efectividad de tratamientos en pruebas clínicas.

Distribución de Poisson

La distribución de Poisson se utiliza para modelar el número de eventos raros en un intervalo de tiempo o espacio fijo, dado una tasa media de ocurrencia. Es comúnmente aplicada en situaciones donde los eventos ocurren de manera independiente y a una tasa constante.

Aplicaciones de la Distribución de Poisson

Negocios: Modelar la llegada de clientes a un banco.

Ingeniería: Evaluar fallos en sistemas técnicos.

Sistemas de salud: Analizar la frecuencia de emergencias médicas.

Organización Temática del Análisis

Pasos para Modelar con Distribución Normal

Recolección de Datos: Obtener un conjunto de datos continuos que sean representativos del fenómeno a estudiar. Es fundamental asegurarse de que los datos sean precisos y confiables, ya que cualquier sesgo o error puede afectar significativamente los resultados del modelado.

Análisis Exploratorio: Visualizar los datos mediante histogramas y otras herramientas gráficas para entender la distribución de los datos. Esto ayuda a identificar patrones, tendencias y posibles anomalías. El análisis exploratorio también incluye la verificación de la normalidad de los datos, utilizando gráficos de probabilidad normal y pruebas estadísticas.

Estimación de Parámetros: Calcular la media (μ) y la desviación estándar (σ) de los datos. Estos parámetros son esenciales para definir la distribución normal. La media representa el valor central de la distribución, mientras que la desviación estándar indica la dispersión de los datos alrededor de la media.

Modelado: Aplicar la distribución normal para análisis y predicciones. Esto implica ajustar los datos a la curva de distribución normal utilizando los parámetros estimados. El modelado puede incluir la generación de intervalos de confianza y la realización de pruebas de hipótesis.

Validación: Evaluar el modelo con nuevos datos para asegurar que la distribución normal es una representación adecuada del fenómeno en estudio. Esto se realiza comparando las predicciones del modelo con los datos observados y utilizando métricas de ajuste como el error cuadrático medio o la prueba de bondad de ajuste.

Pasos para Modelar con Distribución Binomial

Definir el Experimento: Establecer el número de ensayos (n) y la probabilidad de éxito (p) para cada ensayo. Es crucial que los ensayos sean independientes y que cada uno tenga solo dos posibles resultados: éxito o fracaso.

Recolección de Datos: Obtener datos discretos de experimentos o encuestas que se ajusten al modelo binomial. Los datos deben consistir en la cantidad de éxitos en un número fijo de ensayos, asegurando que la condición de independencia se cumpla.

Análisis: Utilizar la distribución binomial para evaluar la probabilidad de diferentes resultados. Este análisis permite calcular la probabilidad de obtener un cierto número de éxitos en los ensayos, lo cual es útil para tomar decisiones basadas en la incertidumbre.

Modelado: Aplicar la distribución binomial en la toma de decisiones. Esto puede incluir la estimación de probabilidades para distintos números de éxitos y el uso de estas probabilidades para informar decisiones estratégicas.

Validación: Comparar los resultados modelados con datos reales para verificar la precisión del modelo. La validación puede incluir la comparación de frecuencias observadas y esperadas, así como el uso de pruebas estadísticas como la prueba de chi-cuadrado.

Pasos para Modelar con Distribución de Poisson

Identificar Eventos Raros: Determinar la naturaleza y frecuencia de los eventos a modelar, asegurándose de que estos sean eventos raros y ocurren de manera independiente en intervalos de tiempo o espacio fijos.

Recolección de Datos: Obtener datos de intervalos de tiempo o espacio fijos que reflejan la ocurrencia de los eventos raros. La calidad y precisión de los datos son esenciales para una modelación efectiva.

Estimación de Parámetros: Calcular la tasa media de ocurrencia (λ), que representa el número promedio de eventos por unidad de tiempo o espacio. Este parámetro es clave para definir la distribución de Poisson.

Modelado: Utilizar la distribución de Poisson para predecir la frecuencia de eventos. Esto implica aplicar la fórmula de la distribución de Poisson para calcular la probabilidad de que ocurra un cierto número de eventos en un intervalo dado.

Validación: Evaluar el modelo con nuevos datos para asegurar que la distribución de Poisson proporciona una representación precisa de la ocurrencia de eventos. La validación incluye la comparación de las predicciones del modelo con los datos observados y el uso de métricas de ajuste como la prueba de bondad de ajuste de Poisson.

Conclusión y Perspectivas Futuras

En conclusión, los modelos de probabilidad son herramientas poderosas en el arsenal de un científico de datos, permitiendo la exploración y el análisis de datos inciertos de manera rigurosa y sistemática. A medida que avanzamos en el campo de la ciencia de datos, es crucial seguir investigando nuevas técnicas y aplicaciones de los modelos de probabilidad para abordar desafíos emergentes en diversas industrias.

¡Descubre cómo los modelos de probabilidad pueden optimizar tu análisis de datos!