Evolución de Algoritmos en IA: Un Viaje Histórico

Introducción

En el vasto mundo de la inteligencia artificial (IA), los algoritmos de machine learning han sido la piedra angular de los avances tecnológicos que presenciamos en la actualidad. Desde los primeros intentos hasta las complejas redes neuronales de hoy en día, el desarrollo histórico de estos algoritmos nos ofrece una fascinante narrativa de innovación, desafíos y logros.

Los Inicios: Fundamentos de los Algoritmos de Machine Learning

En los primeros días de la informática, los pioneros como Alan Turing sentaron las bases teóricas para lo que eventualmente se convertiría en los algoritmos de machine learning. La idea de que las máquinas podrían aprender y adaptarse por sí mismas fue un concepto revolucionario que impulsó décadas de investigación.

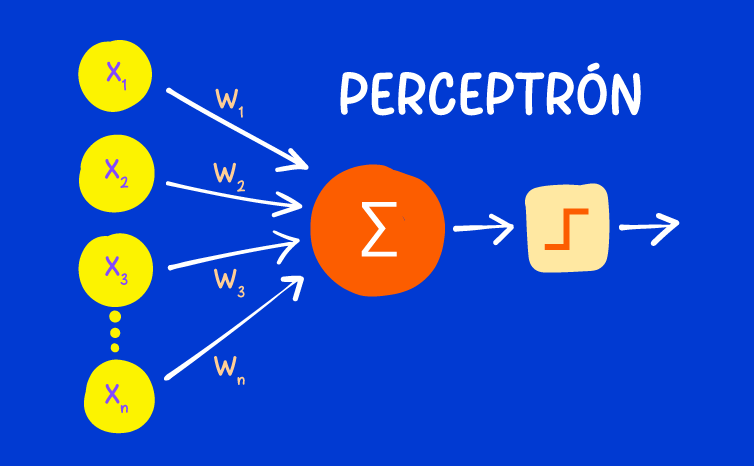

Los pioneros de la IA se enfrentaron al desafío de crear programas capaces de aprender y mejorar con la experiencia. Este período inicial, que abarca desde la década de 1950 hasta la década de 1970, presenció los primeros experimentos con algoritmos de machine learning. Algoritmos simples, como el perceptrón de Frank Rosenblatt, sentaron las bases para futuros desarrollos. Sin embargo, las limitaciones computacionales y la falta de datos de calidad limitaron su aplicación práctica.

Durante los años 50 y 60, se desarrollaron los primeros algoritmos de aprendizaje automático, como los perceptrones de Frank Rosenblatt, sentando las bases para futuros avances. Sin embargo, estas primeras incursiones se vieron limitadas por la disponibilidad de datos y la capacidad computacional.

La Era de los Avances Tecnológicos: Expansión y Diversificación

Con el advenimiento de la computación moderna y el aumento exponencial de la potencia de cálculo, los algoritmos de machine learning experimentaron un renacimiento en las décadas de 1980 y 1990. Se desarrollaron nuevos enfoques y técnicas, como las redes neuronales artificiales y los algoritmos genéticos, que permitieron un aprendizaje más complejo y sofisticado.

Durante este período, los investigadores comenzaron a aplicar los algoritmos de machine learning en una amplia gama de campos, desde la medicina hasta la economía. Los avances en el procesamiento del lenguaje natural y la visión por computadora llevaron a la creación de aplicaciones prácticas y sistemas inteligentes que podían comprender y responder al mundo que los rodeaba.

La Era Moderna: Algoritmos de Machine Learning en el Siglo XXI

En el siglo XXI, los avances en la computación y el acceso a grandes cantidades de datos han catapultado los algoritmos de machine learning a nuevas alturas. La popularización de técnicas como el aprendizaje profundo ha revolucionado industrias enteras, desde la medicina hasta la automoción. Los algoritmos de machine learning ahora son capaces de realizar tareas complejas, como el reconocimiento facial y la traducción automática, con una precisión sin precedentes.

Desafíos y Futuras Direcciones

A pesar de los increíbles avances logrados en el campo del machine learning, los algoritmos aún enfrentan desafíos significativos que deben ser abordados para alcanzar su máximo potencial y garantizar su uso responsable.

Interpretación de Modelos de Aprendizaje Profundo: Los modelos de aprendizaje profundo, como las redes neuronales profundas, son a menudo considerados cajas negras debido a su complejidad. La dificultad para interpretar cómo estos modelos llegan a una determinada conclusión puede ser un obstáculo significativo.

Ética y Equidad en Machine Learning: El desarrollo y la aplicación de algoritmos de machine learning presentan consideraciones éticas y de equidad que son cada vez más importantes. Los sesgos en los datos de entrenamiento pueden llevar a decisiones injustas o discriminatorias. Es esencial desarrollar métodos para identificar y mitigar estos sesgos, asegurando que los algoritmos se comporten de manera justa y equitativa.

Privacidad y Seguridad de los Datos: La cantidad de datos necesarios para entrenar modelos de machine learning plantea preocupaciones sobre la privacidad y la seguridad de la información. Es crucial implementar medidas robustas para proteger los datos sensibles y garantizar que la recolección y el uso de datos cumplan con las regulaciones de privacidad.

Adaptabilidad y Robustez de los Modelos: Los modelos de machine learning deben ser capaces de adaptarse a cambios en los datos y en el entorno en el que operan. La robustez de los modelos frente a datos ruidosos, adversarios y variaciones inesperadas es un área de investigación activa.

Sostenibilidad y Eficiencia Energética: El entrenamiento de modelos de machine learning, especialmente los modelos profundos, puede ser extremadamente costoso en términos de recursos computacionales y energía. La sostenibilidad de estos procesos es una preocupación creciente.

Futuras Direcciones: A medida que avanzamos hacia el futuro, es crucial abordar estos desafíos de manera integral. La investigación y el desarrollo en áreas como la interpretabilidad, la equidad, la privacidad, la adaptabilidad y la sostenibilidad continuarán siendo fundamentales. Además, la colaboración interdisciplinaria entre científicos de datos, ingenieros, expertos en ética, y legisladores será esencial para desarrollar directrices y políticas que guíen el desarrollo responsable de tecnologías de machine learning.

Conclusión: Reflexiones sobre el Pasado, Presente y Futuro

El viaje de los algoritmos de machine learning en la inteligencia artificial ha sido un viaje de descubrimiento, innovación y desafío. Desde sus humildes comienzos hasta su impacto global actual, estos algoritmos han demostrado ser una fuerza impulsora detrás del progreso tecnológico y la innovación.

Sin embargo, a medida que miramos hacia el futuro, es imperativo que abordemos los desafíos éticos y sociales que acompañan a esta revolución tecnológica. Solo mediante un enfoque colaborativo y centrado en el ser humano podemos aprovechar todo el potencial de los algoritmos de machine learning para el bien de la sociedad y el avance de la humanidad. Los algoritmos de machine learning han llegado lejos, pero su viaje está lejos de terminar.

¡Aprende cómo los algoritmos de machine learning están transformando el mundo de la inteligencia artificial!